Recent research overview(2022.10.01)

Distribution Calibration for Out-of-Domain Detection with Bayesian Approximation

论文作者

吴亚楠1, 曾致远1, 何可清1, 牟宇滔, 王霈, 徐蔚然 2

发表会议

COLING2022 Long Paper

论文简介

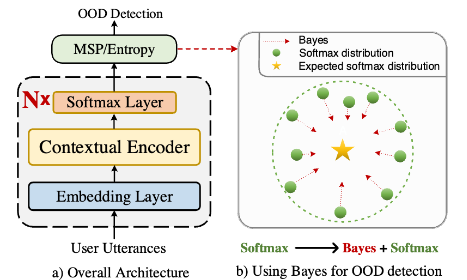

域外(out-of-domain, OOD)检测是任务型对话系统应对开放世界的重要要求,在正确识别预定义意图基础上,旨在检测用户输入query是否超出预定义意图。然而,传统的基于softmax的域外检测算法在域外样本识别上存在过自信问题。本文结合理论分析发现,训练分布与测试分布之间不匹配,使得模型不能自信地做出预测,从而导致softmax分数异常,换句话说,缓解分布不确定性是解决过自信问题的关键。基于此,我们提出了基于贝叶斯估计的域外检测算法,在推理阶段,利用蒙特卡罗Dropout多次传导求期望,以校准分布不确定性,将实际错误的尖锐域外分布校准为接近理想的均匀分布,以便更好的区分域内和域外数据。我们的方法灵活适用于现有的基于概率的域外检测算法,相比于MSP,我们的方法在不增加任何模型参数,仅增加0.41%推理时间消耗上,可以获得了33.33%的OOD F1指标提升。文章中大量的实验和分析进一步证明了贝叶斯学习在OOD检测中的有效性。

代码

Generalized Intent Discovery: Learning from Open World Dialogue System

论文作者

牟宇滔1, 何可清1, 吴亚楠, 王霈,王金刚,武威,黄毅,冯俊兰, 徐蔚然 2

发表会议

COLING2022 Long Paper

论文简介

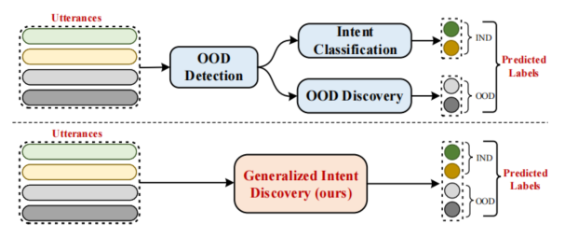

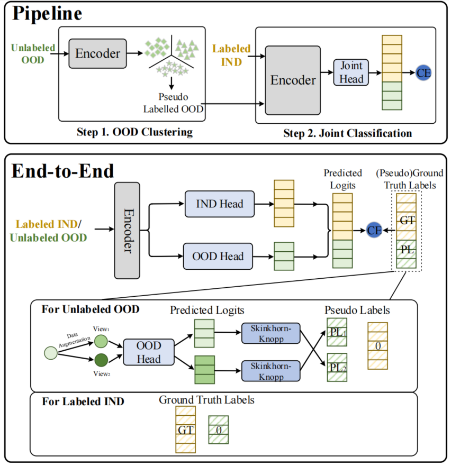

传统的意图分类模型基于领域专家预定义好的域内(IND)意图集,并且只能识别有限的域内意图。然而当对话系统线上部署之后,用户可能会输入域外(OOD)查询。这些OOD数据为系统未来进一步开发提供潜在发展方向。在本文中,我们定义了一个新任务——泛化意图发现(GID),旨在将IND意图分类器的识别范围扩展到包括IND意图和新出现的OOD意图的开放世界意图集中。具体地,我们希望训练一个统一的模型以端到端的方式同时学习分类有标注的域内意图类,以及增量式地从无标注OOD数据中发现和识别的新的域外意图类,以便自动扩展分类器的识别范围,通俗地说就是自动扩充分类头。为了能够在更真实地场景下讨论GID任务,我们构建了三个基准数据集,分别模拟单领域,多领域和跨领域场景,并在此基础上衍生出两个变体数据集,分别模拟真实环境中OOD噪声和OOD类别不平衡场景。在方法上,我们提出了两个框架,pipeline和端到端框架,以便后续GID研究使用。此外,我们还做了大量地分析实验,综合地讨论和分析了GID任务的关键挑战,并为这个方向未来的研究提供了新的指导。

代码

PSSAT: A Perturbed Semantic Structure Awareness Transferring Method for Perturbation-Robust Slot Filling

论文作者

董冠霆1, 郭岱驰1, 王礼文1, 李雪峰1, 王泽晨, 曾晨, 何可清,赵金政, 雷浩,崔馨月,黄毅,冯俊兰, 徐蔚然 2

发表会议

COLING2022 Short Paper

论文简介

大多数现有的槽填充模型倾向于从训练数据中记忆实体的固有模式与对应的上下文。然而,当这些模型暴露于真实场景下的口语扰动时,可能会导致性能下降或产生期望之外的输出。我们提出了一种扰动语义结构感知迁移方法,来训练出对扰动具有鲁棒性的槽填充模型。具体来说,我们引入了两种基于MLM的训练策略,分别从含有无监督语言扰动的语料库中学习上下文语义结构和实体分布。然后,将上游预训练过程中学习到的语义知识迁移到原始样本中,并通过一致性处理模块过滤低质量的增强数据。这些程序旨在提高槽填充模型的鲁棒性。实验结果表明,我们的方法始终优于以往的基本方法,并在防止模型记忆实体和上下文固有模式的同时,获得了较强的泛化性。